Intelligenz – Maschine – Gehirn

Müssen wir Menschlichkeit neu bestimmen?

Zur Konferenz Humanity Defined: Politics and Ehtics in the AI Age des Aspen Institute Germany

Die Rede von der Künstlichen Intelligenz durchdringt seit gut einem Jahr den Wirtschaftsdiskurs. Am 22. Januar 2018 hielt der Präsident und Chief Legal Officer von Microsoft Brad Smith im Microsoft Atrium Unter den Linden seinen Vortrag Künstliche Intelligenz und die Zukunft von Wirtschaft, Arbeit und Gesellschaft.[1] Einen Tag später wiederholte er ihn in Davos. Seither bestimmt die Künstliche Intelligenz die Agenda der Konferenzen. Am 28. und 29. März 2019 lud das renommierte Aspen Institute mit der Heinz und Heide Dürr Stiftung in die Vertretung des Landes Baden-Württemberg beim Bund in der Tiergartenstraße 15 zur KI-Konferenz ein. Microsoft, KI Bundesverband e. V., Pfizer und die amerikanische Aspen Initiative for Europe waren Partner im Aspen Digital Program für Humanity Defined: Politics and Ethics in the AI Age.

In den Tagesthemen am 7. April 2019 um 22:52:56 kündigte die Moderatorin Caren Miosga am Sonntagabend die Dokumentation Der große Umbruch für Montag effektvoll an. Sie sprach mit einer leicht verzerrten Stimme und den Worten: „Es ist ein Phänomen, das längst unseren Alltag beherrscht.“[2] Von Zauberhand oder mit Blue Screen hatte sich die Moderatorin im Studio verdoppelt. Der Automat oder die Künstliche Intelligenz spricht mit Caren Miosga. „Noch arbeiten hier im Studio echte Menschen …“ Dann wird die Eröffnungssequenz zur Doku eingespielt: Zu „Künstliche Intelligenz“ wird die 3D-Animation eines Gehirns rangezoomt, bis sich die Animation in „Neuronale Netze“ als Strahlengraphik mit Verknüpfungspunkten verwandelt. So funktioniert Intelligenz! Wahrlich hier wird „Humanity“ zur Primetime mit animierten Graphikmodellen definiert. – Ist das ethisch?

In der folgenden Besprechung wird der Berichterstatter punktuell auf einzelne Vorträge der Konferenz und Fragen des Verhältnisses von Politik und Ethik im Zeitalter der Künstlichen Intelligenz vertiefend und exkursiv eingehen. Wie wird über Künstliche Intelligenz gesprochen und wie wird sie visuell dargestellt? Wie wird diese Darstellung der Technologie zur Menschlichkeit in Beziehung gesetzt? Welche Unschärfen schwingen mit? Wie wird Ethik formuliert und auf Künstliche Intelligenz angewendet? Gleichzeitig wird zu bedenken gegeben, dass der Ethik-Diskurs zur Künstlichen Intelligenz virulent wurde, nachdem Donald Trump durch eine exzessive Nutzung von Twitter und Facebook sowie Chatbots und Fake News als Künstliche Intelligenz im Wahlkampf 2016 widererwarten zum Präsidenten der USA gewählt wurde. Brad Smith setzte insofern die Agenda von „AI and Ethics“ in Berlin und Davos, nachdem die USA und die amerikanische Demokratie quasi moralisch diskreditiert waren.

Alle sprechen von Künstlicher Intelligenz und ihrer Beherrschung bzw. gesetzlichen Regulierung, die sich die Ministerin für Justiz und Verbraucherschutz Katarina Barley zur Aufgabe gemacht hat. Sie liefert die Keynote auf der Ethikkonferenz und wird in der ARD-Dokumentation vom Wissenschaftsjournalisten und Physiker Ranga Yogeshwar interviewt. Auf der Konferenz sagt sie, dass sie nicht zum Arzt gehen und einem Arztroboter ihre Zunge zeigen möchte. – Liebe Frau Barley, das müssen Sie nicht! Aber sie sollten sich von Ihren Referent*innen Googles „Gesundheitshelferin“ Ada erklären lassen. Die Google-App ist benannt nach Ada Lovelace, die schon 1980 für die Programmiersprache Ada zur Namenspatin gemacht wurde. Sie selbst avanciert mehr und mehr unter feministischen Informatiker*innen zur Mutter der Algorithmen und des Computers.

Der Roboter vereint als „erstklassiges medizinisches Wissen und künstliche Intelligenz … in einer App“, wie Google bzw. Ada Health GmbH es formuliert, und wurde bereits auf vielen Handys der Bundesbürger*innen installiert. Der Arztroboter ist längst da, smart auf dem Handy. – Sie fahren zu selten U-Bahn in Berlin, verehrte Frau Barley. – „Hallo Sarah, ich bin Ada. Ich kann dir helfen, wenn du dich nicht wohlfühlst. Kopfschmerzen? #tellAda Ada kostenlos herunterladen.“ – So spricht Ada Sie z.B. auf dem U-Bahnhof Oranienburger Tor an. Die ARD hat bereits mit Rettungssanitätern Adas Diagnostikkompetenz getestet. Die Rettungssanitäter hätten die gleichen Fragen gestellt und wären von Mensch zu Mensch zu den gleichen Ergebnissen gekommen. Ada kommt auf der Konferenz erst einmal nicht zur Sprache. Woher der Begriff Artificial Intelligence kommt wird vage angedeutet, aber der Schlüsseltext von John von Neumann The Computer and The Brain (1958) nicht erwähnt.[3]

Kein Bereich des Lebens ist stärker durchreguliert als der der Gesundheitsversorgung. Der Körper des Menschen hat sich nicht zuletzt mit den bildgebenden Verfahren der Neurowissenschaften seit den 90er Jahren in eine biologische Maschine verwandelt.[4] Graphikmodelle wie das Gehirn in der eröffnenden Animation der ARD-Dokumentation haben das kursierende Wissen vom Körper und Denken so sehr durchdrungen und verbreitet, dass die Tagesthemen-Redaktion sie nur kurz zeigen braucht. Dann „wissen“ die Zuschauer*innen, worum es geht. Jede Ärzt*in, jede Rettungssanitäter*in folgt einem strikten Fragenkatalog, der durch das Gesundheitssystem geregelt wird. Das Arztgespräch folgt nach eingeübten, hochdifferenzierten und im Gesundheitssystem ausgehandelten Regeln. Die Spielräume sind gering und von Lobbyisten hart umkämpft. Anders gesagt: Das Beispiel, das Katarina Barley prominent und charmant formulierte, verfehlt haarscharf die Frage nach dem Menschen und der Ethik in Zeiten der Künstlichen Intelligenz, weil es aus einem Bereich kommt, der längst im höchsten Maße von Entweder-Oder-Entscheidungen, mit einem anderen Wort Algorithmen und also Künstlicher Intelligenz bis in die kleinste Zelle formatiert ist.

Neben dem Tagungsraum ist ein grüner Rasen ausgerollt und die Künstliche Intelligenz spielt noch etwas ungelenk beim Trippeln Robo Soccer. 2016 nannte man die Spieler gar schon „Humanoide“. Leipzig spielt gegen Berlin, aber es geht irgendwie verdammt langsam. Man muss mit der Künstlichen Intelligenz offensichtlich Geduld haben. Irgendwann rollt der kleine Ball dann doch ins Tor und die Coaches am Spielfeldrand freuen sich wie bei der Kinderliga. Die großen Kunstaugen der Roboter machen die Technologie kindlich und niedlich nach dem japanischen Format des kawaii.[5] Diese Spieler stecken noch in den Kinderschuhen, obwohl sie datenverarbeitungstechnisch schon sehr viel leisten. Währenddessen unterhält sich die Technologiephilosophin Shannon Vallor von der Santa Clara Universität in Kalifornien mit Katarina Barley. Vallor hat zahlreiche Artikel über ethische Fragen zu entstehenden Technologien geschrieben. Sie ist Co-Direktorin der Stiftung für verantwortungsvolle Robotik (Foundation of Responsible Robotics). Google AI führt sie als „AI Ethicist in Google’s Visting Researcher program“.[6]

Die Internetkonzerne sind nicht unbedingt feindlich zur Ethik eingestellt. Das Silicon Valley und Google suchen geradewegs nach Expert*innen für Ethikberatung. Shannon Vallor berät dann hinsichtlich der Konflikte von Shareholder Values und Ethikfragen. Sie hat bei Google eine Reihe von Workshops, Präsentationen und Self-Service Schulungsmodellen über „tech ethics“ der Cloud AI für eine Vielzahl von Zuhörern ausgearbeitet.[7] Ethik lässt sich in der Implementierung von Algorithmen programmieren. Anders gesagt, jede Entweder-Oder-Entscheidung und deren Differenzierung in weitere binäre Fälle letztlich von 0 und 1 trifft eine ethische Auswahl. Shannon Vallor ist mit dem „World Technology Award in Ethics from the World Technology Network“ eine Art Spitzenethikerin, die schon viele Preise im „teaching“ verliehen bekommen hat. Während immer neue Algorithmen geschrieben werden, um die Künstliche Intelligenz leistungsfähiger und schneller zu machen, vermittelt Vallor den Programmier*innen darauf zu achten, welche binären Entscheidungen falsch sein könnten.

Der Bedarf nach Ethik-Kompetenz im Silicon-Valley ist groß. Doch nicht alle werden gefragt. Die Aktivistin und Autorin von Weapons of Math Destruction – How Big Data Increases Inequality and Threatens Democracy Cathy O’Neil bedankte sich auf dem Podium ausdrücklich für die Einladung, weil das in Amerika nicht geschehe. 2016 hat Shannon Vallor Technology and the Virtues in der Oxford University Press veröffentlicht. Noel Sharkey, Professor of Artificial Intelligence and Robotics and of Public Engagement an der University of Sheffield lobt das Buch als „eine wundervoll geschriebene und einnehmende tour de force“, die auch verstanden werden kann, wenn man kein Philosoph ist.[8] Sie wendet „classical philosophical traditions of virtue ethics to contemporary challenges of a global technological society“ an.[9] Welche „Tugenden“ (virtues) könnten hier mit einem „moralischen Raster“ (moral framework) nach aristotelischen, konfuzianischen und buddhistischen Perspektiven formuliert werden?[10] Die Wiederkehr von Tugend und Moral fällt in der Leitlinien-Literatur viel elastischer aus, als das „einnehmend“ formuliert werden kann, weil Sprache zwar befehlsförmig ist, wie es Roland Barthes am 7. Januar 1977 einmal formuliert hat, die Begriffe und Zeichen sich aber ständig verschieben.[11]

In einer, sagen wir, moral-historischen Perspektive ist Shannon Vallors „Philosophical Guide“ durchaus erstaunlich, weil die Rede von der Maschine den Menschen aus der christlichen Morallehre befreien sollte. Bereits die anonym mit einem Motto von Voltaire publizierte Schrift L’HOMME MACHINE von Julien Offray de la Mettrie macht 1748 mit einer philosophisch-aufklärerischen Befreiungsgeste den Menschen zur Maschine. Auf dem Titelblatt der Originalausgabe in der Akademiebibliothek der Berlin-Brandenburgischen Akademie der Wissenschaften ist „L’HOMME“ um mehrere Schrifttypengrade kleiner als „M A C H I N E“ gedruckt.[12] Die skandalöse Schrift wendet sich unter dem Schutz Friedrich II. von Preußen, dem sogenannten Großen, gegen die christlichen Tugenden und Moral. Der Medizinprofessor Haller aus Göttingen kündigt die Maschine in seiner Widmung als neue akademische „Methode“ an.[13] Gleichzeitig wird die christliche Todsünde „La Volupté de sens“ (die Wollust der Sinne) mit der „jouissance“ (dem Genießen) als, sagen wir, Motor der Menschmaschine eingeführt.[14] Der Philosoph Voltaire unterstützt nicht nur de la Mettries neue Methode, vielmehr hatte er bereits um 1740 in seiner ebenfalls anonym kursierenden Legende La Pucelle d’Orleans die Todsünde der Wollust zur Raison d’Être erklärt.

Wenn nun 2016 also die aristotelische, konfuzianische und buddhistische Tugend nach Vallor in die Technologie der Maschine als Künstliche Intelligenz zurückkehren soll, dann kann man das auch als ein Problem der Menschlichkeit verstehen. Denn die Normativität von „Tugenden/virtues“ trägt immer schon einen christlich-europäischen Kontext mit sich. Julien Offray de la Mettries Wollust-Materialismus war indessen so revolutionär, dass die Schrift erst in jüngerer Zeit eine kritische Re-Lektüre erfahren hat. Durch die Philosophin Ursula Pia Jauch ist de La Mettrie 2017 mit dem Band Julien Offray de La Mettrie und Emilie du Châtelet auf der Suche nach dem Glück: Eine weitere Antwort auf die Frage, ob Philosophie im Leben hilft ins Interesse gerückt worden. Holm Tetens hat bereits 1999 L’Homme Machine mit der Neurokybernetik und dem Menschen als „Redetier“ kurzgeschlossen.[15] Das soll hier gar nicht unterstützt werden. Vielmehr soll darauf aufmerksam gemacht werden, dass das Verhältnis von Mensch und Maschine, wie es mit der Künstlichen Intelligenz und der Ethik erneut zur Sprache kommt, ein sehr viel längeres, komplexeres und ambiges ist, als es sich mit einem „moral framework“ erfassen und programmieren lässt.

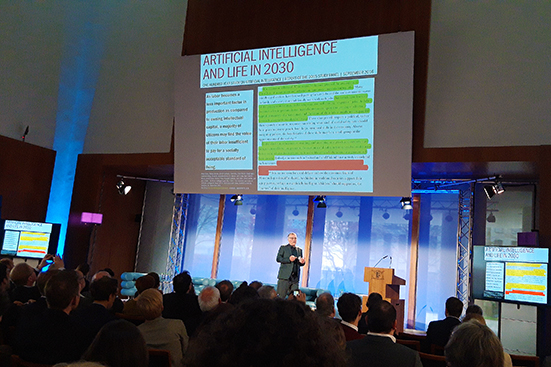

Die Maschine, und damit die Künstliche Intelligenz war immerschon ein Befreiungsversprechen, das als eine Angst vor der Suprematie der Maschine zurückblickte. Dieses Paradoxon gilt es erst einmal wahrzunehmen – und auszuhalten. Der Mainzer Professor für theoretische Philosophie Thomas Metzinger hielt mit seinem Vortrag AI and Ethics: Europe First or Europe Alone? in deutscher Sprache vielleicht den prägnantesten Vortrag der Konferenz. Sein Vortrag wurde simultan ins Englische übersetzt und erhielt in folgenden Vorträgen beispielsweise von Luis Villa mit Humanizing Techonology and Strengthening Democracy: A Strategic Design Perspective entschiedene Unterstützung. Wie wird Technologie menschlicher? Und welche Funktion nimmt Europa in der Ethikdiskussion ein? Thomas Metzinger hat das Open MIND Project gegründet und gehörte zu den 52 Experten der „High-Level Expert Group on Artificial Intelligence“[16] bei der Europäischen Kommission zur Politik des Digital Single Market, die am 8. April 2019 ihre ethischen Leitlinien (guidelines) mit „Seven essentials for achieving trustworthy in AI“ veröffentlichte. Die Pressemeldung war mit „Künstliche Intelligenz: Kommission treibt Arbeit an Ethikleitlinien weiter voran“ übertitelt.

„Sieben Voraussetzungen für eine vertrauenswürdige KI

Eine vertrauenswürdige KI muss alle geltenden Gesetze und Vorschriften einhalten und eine Reihe von Anforderungen erfüllen. Spezifische Bewertungslisten sollen dazu beitragen, die Erfüllung der einzelnen Kernanforderungen zu überprüfen:

Vorrang menschlichen Handelns und menschlicher Aufsicht: KI-Systeme sollten gerechten Gesellschaften dienen, indem sie das menschliche Handeln und die Wahrung der Grundrechte unterstützen‚ keinesfalls aber sollten sie die Autonomie der Menschen verringern, beschränken oder fehlleiten.

Robustheit und Sicherheit: Eine vertrauenswürdige KI setzt Algorithmen voraus, die sicher, verlässlich und robust genug sind, um Fehler oder Unstimmigkeiten in allen Phasen des Lebenszyklus des KI-Systems zu bewältigen.

Privatsphäre und Datenqualitätsmanagement: Die Bürgerinnen und Bürger sollten die volle Kontrolle über ihre eigenen Daten behalten und die sie betreffenden Daten sollten nicht dazu verwendet werden, sie zu schädigen oder zu diskriminieren.

Transparenz: Die Rückverfolgbarkeit der KI-Systeme muss sichergestellt werden.

Thomas Metzinger sparte mit seiner Kritik an den Ethikleitlinien in seinem Vortrag am 29. März in der Landesvertretung Baden-Württemberg nicht. Im Tagesspiegel Background veröffentlichte er seine Kritik als Ethik-Waschmaschinen made in Europe am 8. April erneut.[18] Im Vortrag wie im Background-Artikel erwähnt er ein Telefonat mit dem freundlichen, finnischen Präsidenten der Gruppe, Pekka Ala-Pietilä, in dem er ihn fragte, ob die „Red Lines“ für „nicht-verhandelbare ethische Prinzipien“, für die Veröffentlichung der Ethikleitlinien „die Formulierung „nicht verhandelbar“ nicht doch aus dem Dokument streichen könnten“.[19] Aus der Liste der Mitgliederliste der Gruppe kann man erfahren, dass Ala-Pietilä „Chairman of the Board of packaging company Huhtamaki, media company Sanoma and Netcompany as well as a member oft he Supervisory Board of SAP“ ist. Thomas Metzinger fordert daraufhin: „Nehmt der Industrie die Ethikdebatte wieder weg!“ Als engagierter Ethiker kritisiert er den Begriff der „vertrauenswürdige(n) KI“, weil Künstliche Intelligenz im Unterschied zum Menschen nicht vertrauenswürdig sein könne.

„Wir können es uns nicht leisten, diese Technologie politisch auszubremsen oder nicht weiter zu entwickeln. Weil gute KI aber ethische KI ist, haben wir jetzt auch eine moralische Verpflichtung, die Guidelines der High-Level Group selbst aktiv weiterzuentwickeln. Bei aller Kritik an ihrer Entstehung – die Ethik-Leitlinien, die wir uns in Europa gerade erarbeiten, sind trotzdem die beste Plattform für die nächste Phase der Diskussion, die wir je hatten. China und die USA werden sie genau studieren.[20]“

Zu den Schlüsseltexten der Rede von der Künstlichen Intelligenz gehört John von Neumanns 1958 postum veröffentlichte Schrift The Computer and The Brain. Man kann, wie es wiederholt und beharrlich geschieht, diesen Text als einen geradezu prophetischen lesen, der sich heute mit der Analogie von Computer und Gehirn als Künstliche Intelligenz nicht zuletzt in den animierten Graphiken einer ARD-Dokumentation verwirklicht. Oder man kann John von Neumanns zusammengefasste Vorträge als einen Mythos eben dieser Analogie analysieren, wie es kürzlich Benjamin Peters mit seinem Essay The Computer Never Was A Brain or the Curious Death and Designs of John von Neumann getan hat.[22]

„Even when it was most tempting, John von Neumann resisted the neuro-hubris of the computer-brain analogy he helped create. Indeed, in his deathbed lectures The Computer & the Brain, he grants certain aspects of the analogy “absolute implausibility”.“[23]

Obwohl John von Neumann der Computer-Gehirn-Analogie nach Benjamin Peters widerstand, wurde sie zum wirkungsmächtigen Wissensformat. Peters analysiert von Neumanns Wunsch, als tödlich an Krebs erkrankter Wissenschaftler durch Kombination von Computer und Gehirn überleben zu wollen, sehr genau nicht zuletzt in ethisch-moralischer Hinsicht. Denn John von Neumann nahm als Regierungsberater und Mitglied des Target Commitee entschieden Anteil am Abwurf der Atombomben über Hiroshima und Nagasaki. Schon im Manhattan Projekt von Los Alamos war er 1943 Berater zur Konstruktion und Tests der Atombombe. An der Weiterentwicklung des amerikanischen Atombombenprogramms und der Wasserstoffbombe wie ihrem Test in der Operation Castle 1954 im Bikini-Atoll, bei dem 236 Bewohner der Insel Rongelap verstrahlt wurden, nahm John von Neumann maßgeblich teil.

„Rarely more than one step removed from the legend and lore of the American superpower science, von Neumann’s final published work brought together the issues of computers, minds, and (given his irradiated, failing health) mechanized death in the prestigious Silliman Lectures that he gave at Yale University in 1956, which was posthumously published in 1958 as the unfinished book The Computer & the Brain.“[24]

Benjamin Peters hat nicht zuletzt auf das moralische Problem von Überlebenswunsch und Mitverantwortung an millionenfachem Tod hingewiesen: „His death signals a stirring reminder that even the most “open minds” in the midcentury were willing to calculate mega-deaths of others without ever fully reconciling with one’s own.“[25] Der Computer kann das Gehirn nicht ersetzen und John von Neumanns Denken konnte nicht in einer Künstlichen Intelligenz fortleben. Die Endlichkeit des menschlichen Lebens ist mit der der Intelligenz verkoppelt. In seiner Sterbestunde verlangte John von Neumann nach einem katholischen Priester, um die Krankensalbung oder letzte Ölung zu empfangen. Sie kann mit einer Beichte verknüpft werden, um die Schuld des menschlichen Lebens zu mildern. Intelligenz und Ethik treten gerade bei John von Neumann in ein katastrophisches Verhältnis. Über seine ethische Verantwortung machte sich der hoch intelligente Theoretiker und Mathematiker offenbar wenig Gedanken. Vielleicht muss man in der aktuellen Diskussion die Ursprünge des Buches The Computer & the Brain häufiger in Erinnerung rufen.

Torsten

Flüh

[1] Vgl. dazu Torsten Flüh: Kant und die Ethikrichtlinien aus dem Internetkonzern. Brad Smith stellt The Future Computed im Microsoft Atrium in Berlin und beim Weltwirtschaftsgipfel in Davos vor. In: NIGHT OUT @ BERLIN Januar 29, 2018 19:01.

[2] Tagesthemen Sonntag, 7. April 2019 ab 00:07:56 bis 00:10:37 in der Mediathek.

[3] Vgl. zu John von Neumanns The Computer and The Brain auch Torsten Flüh: Künstliche Intelligenz und Monstera deliciosa. Sabine Bendiek von Microsoft Deutschland lädt zum Parlamentarischen Abend über Künstliche Intelligenz. In: NIGHT OUT @ BERLIN Juli 5, 2018 19:44.

[4] Siehe den Beitrag über die Walter-Höllerer-Vorlesung des Neurowissenschaftlers Wolf Singer: Torsten Flüh: Über die Verabschiedung des Ichs in die neuronalen Netze. Wolf Singers Walter-Höllerer-Vorlesung 2011 in der Technischen Universität Berlin. In: NIGHT OUT @ BERLIN Juni

19, 2011 23:24.

[5] Zum Begriff des kawaii im Manga und Cosplay vgl. Torsten Flüh: Der Mensch als Comicfigur. Zum Cosplay Corner und der Deutschen Cosplay Meisterschaft auf der Frankfurter Buchmesse 2017. In: NIGHT OUT @ BERLIN Oktober 21, 2017 17:19.

[6] Google AI Shannon Vallor https://ai.google/research/outreach/visiting-researcher-program/shannon-vallor/

[7] Ebenda.

[8] Shanon Vallor: Technology and the virtues. A Philosophical Guide to a Future Worth Wanting. New York: Oxford University Press, 2016. Reviews and Awards.

[10] Ebenda.

[11] „Sobald sie (die Rede) hervorgebracht wird, und sei es im tiefsten Innern des Subjekts, tritt die Sprache in den Dienst einer Macht. Unweigerlich zeichnen sich in ihr zwei Rubriken ab: die Autorität der Behauptung und das Herdenhafte der Wiederholung.“ Roland Barthes:Leçon/Lektion. Frankfurt am Main: edition suhrkamp, 1980. S. 19.

[12] Julien Offray de La Mettrie: L’Homme Machine. Leiden: Elie Luzac Fils, 1748. (Digitalisat)

[13] Ebenda S. 4.

[14] Ebenda S. 5

[15] Holm Tetens: Die erleuchtete Maschine. Das neurokybernetische Modell des Menschen und die späte Ehrenrettung für den Philosophen Julien Offray de La Mettrie. In: Die Zeit 10. Juni 1999, 14:00 Uhr.

[16] European Commission: High-Level Expert Group on Artificial Intelligence. (8. April 2019)

[17] Europäische Kommission: Pressemitteilung: Künstliche Intelligenz: Kommission treibt Arbeit an Ethikleitlinien weiter voran. Brüssel, 8. April 2019.

[18] Thomas Metzinger: Ethik-Waschmaschinen made in Europe. In: Tagesspiegel Background 08.04.2019.

[19] Hervorhebung im Original. Ebenda.

[20] Ebenda.

[21] Sigmund Freud: Die Zukunft einer Illusion. IX. Kapitel. (Gutenberg)

[22] Benjamin Peters: The Computer Never Was a Brain, or the Curious Death and Designs of John von Neumann. In: Jeannie Moser / Christina Vagt (Hg.): Verhaltensdesign. Technologische und ästhetische Programme der 1960er und 1970er Jahre. Paderborn: transkript, 2018, S. 113-124. (Open Access)

[23] Ebenda S. 113.

[24] Ebenda S. 115.

[25] Ebenda S. 122.

4 Kommentare